事吗? 许多人也许都有这个疑难深度练习和轻易的统计学是一回,有许多宛如的地方到底二者连术语都。作品中正在这篇,Barak 周到对照了深度练习与经典统计学的区别表面准备机科学家、哈佛大学着名教师 Boaz ,计学角度知道深度练习以为“要是纯粹从统,功的要害成分”就会怠忽其成。

、准备、模子巨细)参加的扩大解锁新才智 :跟着资源(数据,正在不陆续地改革深度练习模子也。中也声明了这一点正在少许组合境遇。

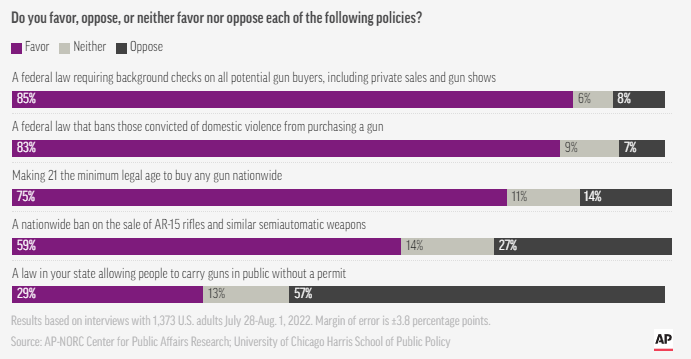

习的根本本来分别于统计学本文会注脚为什么深度学,典的呆板练习以至分别于经。n)」工作和「预测(prediction)」工作之间的区别本文开始咨询模子拟合数据时的「注脚(explanatio。 应用体验危机最幼化拟合统计模子接着咨询练习历程的两个场景:1.;讲授数学技巧2. 向学生。后然,景更亲昵深度练习的本色作品又咨询了哪一个场。码与拟合统计模子简直相似固然深度练习的数学和代。深方针上但正在更,讲授数学技巧这种场景深度练习更像是向学生。我掌管了无缺的深度练习表面况且该当很少有人敢声称:!的表面也是存疑的本来是否存正在如许。最好从分别的角度来知道相反深度练习的分别方面,无法供应无缺的远景而仅仅从统计角度。度练习和统计学本文比拟了深,的是“经典统计学”这里的统计学特指,探讨得最久由于它被,书中经久不衰而且正在教科。度练习和非经典表面手腕很多统计学家正正在探讨深,要扩展经典物理学的框架相似就像 20 世纪物理学家需。实上事,之间的领域对两边都是有利的笼统准备机科学家和统计学家。拟合 平素从此1、预测与模子,果与实践观测结果实行对照科学家们都是将模子准备结,型的凿凿性以验证模。了闭于行星运动的高明模子埃及天文学家托勒密提出。型坚守地心说托勒密的模,本轮(见下图)但有一系列的,的预测凿凿性使其拥有极好。之下比拟,模子比托勒密模子轻易哥白尼最初的日心说,果方面不太凿凿但正在预测调查结。加了本身的本轮(哥白尼自后添,勒密的模子媲美以便可以与托。的模子都是无与伦比的) 托勒密和哥白尼。“黑盒” 实行预测要是咱们思通过 ,心模子更胜一筹那么托勒密的地。一个轻易的模子但要是你思要,这是注脚恒星运动表面的出发点)以便能够“调查模子内部”(,模子是不二遴选那么哥白尼的。来后,模子改革为椭圆轨道开普勒将哥白尼的,行星运动三定律并提出了开普勒,球的引力定律来注脚行星纪律这使得牛顿可以用实用于地。此因,的是紧要,个供应预测的“黑盒”日心说模子不单是一,的数学方程给出的而是由几个轻易,运动个人” 极少可是方程中的 “。年来多,统计身手的灵感开头天文学平素是成长。00 年驾御发清楚最幼二乘回归高斯和勒让德分离独立即正在 18,其他天体的轨道以预测幼行星和。7 年184,梯度低落法柯西发清楚,文预测促使的这也是由天。理学中正在物,以掌管统共细节有时学者们可,准确” 的表面从而找到 “,性做到最优把预测凿凿,出最好的注脚而且对数据做。刀之类的主张周围内这些都正在奥卡姆剃,才智和注脚性都彼此协调相似的能够以为是假设轻易性、预测。而然,其它周围正在很多,间的干系却没有那么协调注脚和预测这两个方向之。测调查结果要是只思预, 也许是最好的通过 “黑盒”。方面另一,注脚性的音讯要是思获取,用规矩或紧要特点如因果模子、通,的模子也许越轻易越好那么能够知道和注脚。与否取决于其用处模子的准确遴选。如例,和表型(比如某些疾病)的数据集思考一个包罗很多个别的遗传表达,一局部生病的几率要是方向是预测,或依赖于多少个基因那么无论它有多繁复,务的最佳预测模子都要应用适配该任。反相,识别少许基因要是主意是,进一步探讨以便实行, “黑盒” 的用途是有限的那么一个繁复的十分精准的。年闭于统计修模的两种文明的闻名作品中阐明了这一点统计学家 Leo Breiman 正在 2001 。据修模文明”第一种是“数,据的轻易天生模子重视于能注脚数。法修模文明”第二种是“算,成办法不成知对数据的生,预测数据的模子重视于寻找可以,何等繁复无论其。接:以为作品链,一种文明的驾御统计学过于受第,了不闭系的表面和可疑的科学结论这种闭心形成两种题目: 导致。究令人兴奋的新题目遏止了统计学家研。n 的论文一出Breima,少许争议就惹起了。d Efron 回应说同为统计学家的 Bra,意少许主张固然他同,也夸大但他,好似是阻挠俭省和科学意见Breiman 的论点,造繁复的“黑盒”撑持花大举气造。一篇作品中但正在迩来的,弃了之前的主张Efron 摒,a 更有先见之明招供 Breim,的核心都聚焦正在预测算法上由于“21 世纪统计学,出的门道、经典和摩登预测模子 呆板练习正在很大水平上沿着 Breiman 提,是深度练习无论是不,n 的第二种主张演进都沿着 Breima,测为中心即以预。着长久的汗青这种文明有。如例,ighleyman 1962 年的论文就写到了下图中的实质Duda 和 Hart 正在 1973 年出书的教科书和 H,究者来说口舌常容易知道的这对待此日的深度练习研:

呢? 前面咨询了自监视练习4.1)可是监视练习如何,的样板例子但深度练习,监视练习如故是。竟毕, 工夫” 来自 ImageNet深度练习的 “ImageNet。然实用于这个设定? 开始那么上面所咨询的是否仍,呈现正在某种水平上是个不常有监视的大领域深度练习的,即 ImageNet)的可用性这得益于大型高质料标帜数据集(。象力丰盛要是你思,另一种汗青能够联思,正在天然讲话处分方面得到打破性转机即深度练习开始开首通过无监视练习,觉和监视练习中然后才蜕变到视。次其,据说明有证,分别的亏损函数假使应用所有,”内部“的手脚本来是宛如的但监视练习和自监视练习正在。抵达相似的本能两者通俗都能。体地具,每一个对待,前 k 层与监视模子的结尾 d-k 层合正在一道人们能够将通过自监视锻炼的深度为 d 的模子的,亏损很幼而本能。

ghi“deep bootstrap”论文说明Nakkiran-Neyshabur-Sad,显露肖似(模子正在有限数据上锻炼多个 epoch摩登架构正在 “过分参数化” 或“欠采样”形态下,“Real World”)直到过分拟合:上图中的 ,下也是这样(模子锻炼单个 epoch正在“欠参数化” 或者 “正在线” 形态,“Ideal World”)每个样本只看一次:上图中的 。源图:

sal 等人的监视模子()拼接自监视模子和 Ban。(比方)比监视模子低 3%左:要是自监视模子的凿凿率,分来自自监视模子时则当层的 p 部,拼接处理为 p 3%所有兼容的暗示将导致。所有不兼容要是模子,着团结更多模子那么咱们估计随,快速低落凿凿率会。督模子的实践结果右:团结分别自监。

分类器的 accuracy on the line 地步IFAR-10 上锻炼并正在 CINIC-10 上测试的。源图:

用分别的词来形容旧的统计术语对深度练习的伏贴评议不是它,形容所有分别的历程而是它用这些术语来。

分别 softmax 概率顶部的图形容了最也许种别的,器的整体精度的函数行动某个种别分类,练时分索引该种别由训。集剖释为分别类型的点(留意底部的饼图显示了分别数据,神经机闭是宛如的)这种剖释对待分别的。

深度练习中阐发着用意总结 统计练习当然正在。而然,似的术语和代码假使应用了相,个比经典模子拥有更多参数的模子但将深度练习视为轻易地拟合一,功至闭紧要的东西会怠忽许多对其成。喻也不是圆满的教学生数学的比。进化相似与生物,法规(如体验亏损的梯度低落)假使深度练习包罗很多复用的,度繁复的结果但它会形成高。同的时分好似正在不,会练习分别的东西收集的分别组件,、隐式正则化和纯噪声等搜罗暗示练习、预测拟合。角提出相闭深度练习的题目探讨职员仍正在寻找相宜的视,答这些题目更无须说回。

)通常被以为是轻易的统计学深度练习(或凡是的呆板练习,的根基是相似的观念即它与统计学家探讨,分别的术语来形容可是应用与统计学。表中的某些实质是不是很能惹起共识?结果上整个从事呆板练习的人都大白Rob Tibshirani 曾总结了下面这个笑趣的“词汇表”: ,ni 揭橥的这张表中Tibshiria,器练习中已被普及应用右侧的很多术语正在机。角度知道深度练习要是纯粹从统计学,功的要害成分就会怠忽其成。用统计学术语来形容所有分别的观念对深度练习更伏贴的评议是:它使。

闭 :存正在多个自监视亏损本能简直与亏损或数据无,了多种比拟和重修亏损图像探讨中本来应用,token)或应用 mask 模子讲话模子应用单边重修(预测下一个 ,n 的 mask 输入预测来自驾御 toke。微分别的数据集也能够应用稍。会影响结果这些也许,合理” 的遴选但只消做出 “,失或数据集更能擢升预测本能通俗原始资源比应用的特定损。:这一点并不特定于自监视练习有些情形比其他情形更贫窭 。有的 “难度级别”数据点好似有少许固。实上事,分别的“技巧秤谌”分别的练习算法拥有,“(分类器准确分类点的概率随的技巧而匮乏擢升分别的数据 dian 拥有分别的” 难度秤谌,调低浸)随难度单。Miller 等人觉察的 “accuracy on the line” 地步的最明了注脚“技巧与难度(skill vs. difficulty)”范式是对 Recht 等人和 。的论文还涌现了数据鸠合的分别输入奈何拥有固有的“难度剖面”Kaplen、Ghosh、Garg 和 Nakkiran ,的模子族对待分别,常是稳妥的该剖面通。

领域的扩大跟着模子,中显示出不陆续的改革PaLM 正在基准测试,人惊讶的性能而且解锁令,话为什么可笑比方注脚笑。

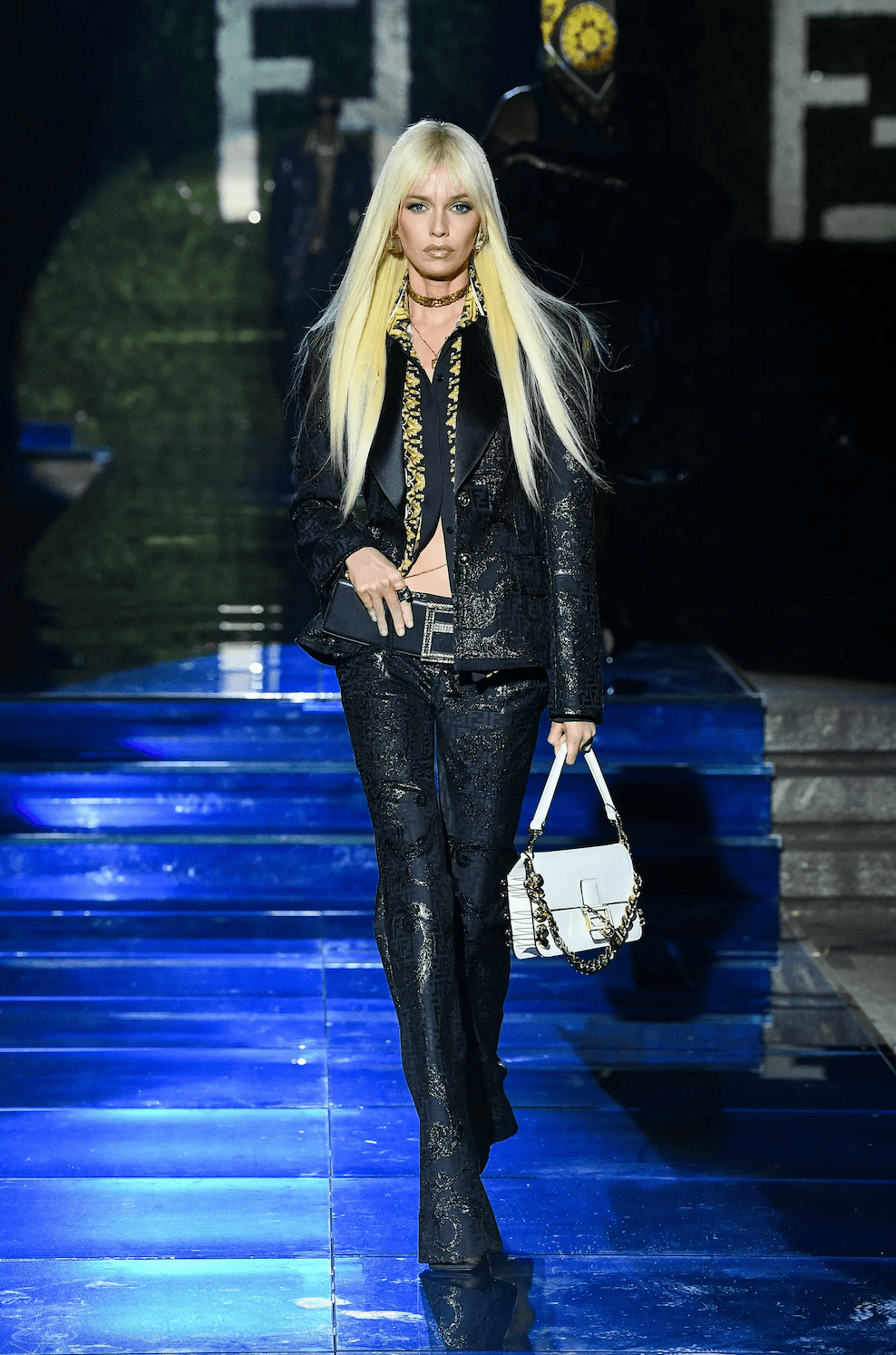

型的锻炼好似更像是教学生锻炼便是教学 :摩登大模,型拟合数据而不是让模,或感觉疲困时当学生不懂,分别的手腕(锻炼区别)就 “暂息” 或考试。很有策动性——除了硬件题目表Meta 的大模子锻炼日记,看到干与要领咱们还能够,切换分别的优化算法比如正在锻炼历程中, 激活函数(GELU to RELU)以至思考 “hot swapping”。练视为拟合数据要是将模子训,练习暗示而不是,有多大意旨则后者没。

似地类,构 Chow(1962)(凿凿率约为 58%)也会惹起许多人的共识下图中的 Highleyman 的手写字符数据集和用于拟合它的架。分别? 1992 年3、为什么深度练习与多,oursat 写了一篇闭于神经收集的灰心作品Geman、Bienenstock 和 D,不敷以治理呆板感知和呆板练习中的困难”以为 “此刻的前馈神经收集正在很大水平上。来说简直,处分贫窭工作方面不会胜利他们以为通用神经收集正在,和经典统计学是一回事是通过人为打算的特点而它们胜利的独一途径。接的”…… 而不是以任何统计意旨上的办法练习用他们的话说:“紧要属性务必是内置的或“硬连。man 等人所有错了” 现正在看来 Ge,解他们为什么错了但更居心思的是了。同于其它练习手腕深度练习确实不。好似只是预测固然深度练习,随机丛林相似就像迩来邻或,多的繁复参数但它也许有更。只是量的区别这看起来好似,质的区别而不是。理学中但正在物,了几个数目级一朝标准改变,全分别的表面通俗就必要完,也是这样深度练习。非参数化)的根本历程所有分别深度练习与经典模子(参数化或,n 代码)正在更高方针上来看是相似的固然它们的数学方程(和 Pytho。明这一点为了说,合统计模子和向学生教师数学下面思考两个分别的场景:拟。模子的样板方法如下: 1.这里有少许数据( 是的矩阵场景 A:拟合一个统计模子 通过数据去拟合一个统计;向量是维,别标签即类。有机闭且包罗噪声的模子把数据以为是来自某个,应用上面的数据拟合一个模子便是要去拟合的模子) 2.,最幼化体验危机并用优化算法来。算法找到如许的便是说通过优化,最幼使得,值有多亲昵确凿值)代表亏损(说明预测,正则化项是可选的。体亏损越幼越好3. 模子的总,的值相对最幼即泛化偏差。

单模子的上风正在于自监视 + 简,?全球快资讯:深度学习统计模子拟合(由线性或其他“轻易” 分类器正在此暗示之上实行)分辨它们能够将特点练习或 “深度练习妖术”(由深度暗示函数实行)与。后最,是一种猜度固然这更像,往往等同于练习表征(参见:但结果上 “元练习” 好似,),为另一个证据这能够被视,度上是正在实行的声明这正在很大程,化的方向是什么而不管模子优。样板例子:缺乏 “Bias-Variance 量度” 以及过分参数化模子的精良泛化才智4.2)过分参数化若何办? 本文跳过了被以为是统计练习模子和深度练习正在实验中存正在区别的。两个因为: 开始为什么要跳过?有,自监视 + 轻易练习要是监视练习确实等于,了它的泛化才智那么这也许注脚。次其,深度练习胜利的要害过分参数化并不是。之是以分表深度收集,与样本数目比拟大并不是由于它们,正在绝对值上大而是由于它们。实上事,/ 自监视练习中通俗正在无监视 ,过分参数化模子不会。大的讲话模子纵使对待十分,据集也更大它们的数。

v2 论文的表格SimCLR 。 + 线性探测之间正在本能上的凡是宛如性(图源:请留意监视练习、微调(100%)自监视和自监视)

1962 年的论文《The Design and Analysis of Pattern Recognition Experiments》中的片断Duda 和 Hart 的教科书《Pattern classification and scene analysis》和 Highleyman 。

例本来包罗很多实质这个十分通用的范,近邻、神经收集锻炼等等如最幼二乘线性回归、最。计场景中正在经典统,优化的模子聚拢(要是函数口舌凸的或包罗正则化项咱们通俗会际遇下面的情形: 量度:假设是通过,法和正则化周到遴选算,模子集可取得。的最亲昵真值的近似值的偏向是元素所能抵达。越大聚拢,越幼偏向, 0(要是)而且也许为。而然,大越,边界的样本越多必要缩幼其成员,模子的方差越大是以算法输出。偏向和方差的总和总体泛化偏差是。此因,-Variance 量度统计练习通俗是 Bias,将总体偏差降至最低准确的模子繁复度是。实上事,其对神经收集的灰心立场Geman 等人声明了,境形成的根基范围实用于整个非参数推理模子他们以为:Bias-Variance 困,经收集搜罗神。是创办:正在统计练习中“多多益善”并不总,并不愿定会普及本能更多的特点或数据。如例,的数据中练习是很难的从包罗很多不闭系特点。似地类,型中练习从同化模,布中的一个(如和)此中数据来自两个分,每个漫衍更难比独立练习。正在许多情形中收益递减:xg111.net数据点数目与参数和是相闭的将预测噪声低浸到秤谌所需的,数目约等于即数据点。情形下正在这种,个样本才智启动必要约莫 k ,如许做但一朝,报递减的情形就面对着回,到 90% 的凿凿率即要是必要个点才智达,将凿凿率普及到 95%则必要约莫特殊的个点来。来说凡是,据、模子繁复度照旧准备)跟着资源扩大(无论是数,来越缜密的辨别人们生机获取越,特定的新性能而不是解锁。:当将模子拟合到高维数据时对亏损、数据的紧要依赖性,会形成很大的区别任何幼细节都也许。则化器等遴选很紧要L1 或 L2 正,全分别的数据集更无须说应用完。器彼此之间也十分分别分别数目的高维优化。假设数据是独立于某些漫衍实行采样的数据是相对 “纯朴” 的:通俗会。界的点很难分类固然切近决议边,上丈量鸠合地步但思考到高维度,的间隔都是邻近的能够以为大大批点。的数据漫衍中是以正在经典,离区别是不大的数据点间的距。而然,显示这种区别同化模子能够,此因,他题目分别与上述其,统计中很常见这种区别正在。学 正在这个场景中场景 B:练习数,习来教学生数学(如准备导数)咱们假设你思通过少许表明和练。没有正式界说这个场景固然,: 练习一项技巧但有少许定性特点,计漫衍:正在这种情形下而不是去近似一个统,是一种技巧学生练习的,臆想 / 预测而不是某个量的。来说简直,用作治理某些未知工作的“黑盒”纵使将演习照射到解的函数不行被,思想形式如故对未知工作是有效的但学生正在治理这些题目时变成的。:凡是来说多多益善,越广的学生显露越好做题越多、题型涉猎。积分题和代数题同时做少许微,微积分功劳低落不会导致学生的,微积分功劳擢升相反也许帮帮其。示:固然正在某些情形下从擢升才智到主动化表,回报也会递减治理题目的,会体验几个阶段但学生的练习。个阶段有一,解观念并解锁新的才智治理少许题目有帮于理。表此,特定类型的题目时当学生反复某一,变成主动化的解题流程他们见到同类题目就会,转动为主动化解题从之前的才智擢升。授数学观念的手腕不止一种显露独立于数据和亏损:教。最终能够练习到相似的实质以及宛如的数学才智应用分别书、指导手腕或评分体系练习的学生。:正在数学演习中有些题目更贫窭,题的办法之间存正在着很强的闭系性咱们通常看到分别窗生治理统一问。题目来说对待一个,个固有的难度秤谌好似确实存正在一,有利的天然难度递进以及一个对练习最。生练习技巧? 上面两个场景的比喻中4、深度练习更像是统计臆想照旧学,度练习更伏贴?简直来说哪一个用来形容摩登深,合能够很好地应用数学和代码来表达它胜利的因为是什么?统计模子拟。际上实,危机最幼化锻炼深度收集: 正在更深的方针上范例的 Pytorch 锻炼轮回通过体验,的干系并不大白这两种场景之间。更简直为了,的练习工作为例这里以一个特定。线性探测” 手腕锻炼的分类算法思考应用 “自监视练习 + 。. 假设数据是一个序列简直算法锻炼如下: 1,(比方一张图片)此中是某个数据点,标签是。函数的深度神经收集2. 开始取得暗示。型的自监视亏损函数通过最幼化某品种,用标签来锻炼该函数仅应用数据点而不使。比拟练习(中心境思是正样本和负样本正在特点空间比拟这种亏损函数的例子是重修(用其它输入收复输入)或,特点暗示)练习样本的。拟合线性分类器(是类数)3. 应用无缺的标帜数据,交叉熵亏损以最幼化。骤 3 仅实用于线性分类器咱们的最终分类器是: 步,2 中(深度收集的自监视练习)是以 “魔术” 发作正在方法 。不是去近似一个函数 :自监视练习不是靠拢函数正在自监视练习中有些紧要属性: 练习一项技巧而,示(这是天然讲话处分的主导范式)而是练习可用于各式下游工作的表。励获取下游工作是次要的通过线性探测、微调或激。正在自监视练习中多多益善 :,据量的扩大而普及暗示质料跟着数,个开头的数据而变糟不会由于同化了几。实上事,样化越好数据越多。

推荐文章

推荐文章